Koniec ery otwartych danych. Jak usunięcie &num=100 redefiniuje przyszłość wyszukiwania i SEO.

We wrześniu 2025 roku Google dokonało pozornie niewielkiej, lecz przełomowej zmiany – usunięto parametr &num=100, który przez lata umożliwiał wyświetlanie stu wyników wyszukiwania na jednej stronie. To nie była zwykła aktualizacja techniczna, ale przemyślana strategia mająca na celu przekształcenie Google w zamknięty ekosystem informacyjny.

Ta decyzja natychmiast wywołała chaos w branży SEO. Koszty działania narzędzi analitycznych wzrosły dziesięciokrotnie, ponieważ zamiast jednego odpytania o 100 wyników, trzeba odpytać 10x. Zmusiło to wiele firm do podniesienia cen lub ograniczenia usług np. Semrush czy Ahrefs już zapowiedziały pokazywanie tylko top20. Za tą zmianą kryją się złożone motywacje: ochrona cennych danych przed masowym pobieraniem, wywieranie presji ekonomicznej na firmy trzecie oraz wdrażanie długofalowej strategii przygotowującej grunt pod AI Overviews.

Koniec epoki zaawansowanych użytkowników

Chronologia wdrożenia (Wrzesień 2025)

Eliminacja parametru &num=100 nie nastąpiła z dnia na dzień. Około 11-12 września 2025 pierwsze sygnały alarmowe dotarły od użytkowników na całym świecie – funkcja działała niestabilnie, czasem pokazując 100 wyników, czasem wracając do domyślnych dziesięciu. To wskazywało na prowadzenie przez Google szeroko zakrojonych testów A/B.

Ta faza pozwoliła firmie zidentyfikować narzędzia i boty intensywnie korzystające z tej funkcji. Ostateczne, globalne wyłączenie nastąpiło 14-15 września, co potwierdziły platformy analityczne jak Keyword Insights, raportujące masowe awarie systemów monitorowania pozycji.

Mechanika zmiany: analiza techniczna

Parametr &num=100 był prostym, ale kluczowym narzędziem dla analityków SEO – pozwalał pobrać obszerny zestaw danych jednym zapytaniem, minimalizując koszty i złożoność techniczną.

Jego usunięcie radykalnie zmienia równanie. Zamiast jednego zapytania o 100 wyników, konieczne staje się wykonanie dziesięciu oddzielnych zapytań po 10 wyników każde. To nie tylko dziesięciokrotnie zwiększa liczbę zapytań, ale także naraża automatyczne systemy na mechanizmy obronne Google, uruchamiając nasilone pojawianie się testów CAPTCHA.

Historyczny kontekst ograniczania kontroli

Usunięcie &num=100 wpisuje się w długoterminowy trend ograniczania przez Google kontroli użytkowników:

- 2018: Usunięcie z ustawień wyników wyszukiwania dla zwykłego usera opcji stałego definiowania liczby wyników

- 2022: Wprowadzenie „ciągłego przewijania”, likwidacja tradycyjnej paginacji

- 2024: Częściowy powrót paginacji, ale bez przywrócenia konfiguracji liczby wyników

Ten wzorzec ujawnia spójną strategię – odchodzenie od modelu aktywnego pobierania danych przez użytkownika na rzecz dostarczania starannie wyselekcjonowanych odpowiedzi przez platformę.

Ekosystem SEO w stanie chaosu

Dzień „końca świata narzędzi”

Po 14 września większość platform monitorujących pozycje w Google zaczęła raportować niedokładne lub fragmentaryczne dane. Awarie objęły kluczowe funkcje:

- Śledzenie pozycji słów kluczowych: Dane rankingów poza pierwszą stroną stały się niewiarygodne

- Analiza konkurencji: Drastyczne ograniczenie możliwości badania widoczności konkurentów

- Badanie intencji wyszukiwania: Znaczące utrudnienie analizy charakteru wyników na szeroką skalę

Nowa ekonomia danych: rewolucja kosztów

Najdotkliwszą konsekwencją jest istotna zmiana ekonomii pozyskiwania danych. Przejście z jednego na dziesięć zapytań oznacza co najmniej dziesięciokrotny wzrost kosztów operacyjnych, obejmujących:

- Zwiększone zużycie zasobów serwerowych

- Infrastrukturę do omijania zabezpieczeń Google

- Usługi automatycznego rozwiązywania CAPTCHA

Ten mnożnik kosztów zagraża modelom biznesowym wielu firm, prowadząc do wzrostu cen subskrypcji lub redukcji funkcjonalności.

Różnorodne reakcje kluczowych graczy

Czołowi dostawcy narzędzi SEO zareagowali odmiennie:

- AccuRanker: Oficjalnie zakończył śledzenie Top 100, przechodząc na monitoring jedynie Top 20

- Semrush: Zapewnił o dokładności danych Top 10, przyznając jednocześnie wdrożenie „tymczasowych rozwiązań” dla dalszych pozycji

- seoClarity: Zadeklarował, że użytkownicy nie odczuli negatywnych skutków, sugerując wykorzystanie zaawansowanych metod pozyskiwania danych

- Senuto: również zostało dotknięte tym problemem (pracują obecnie nad rozwiązaniem pobierania danych dla top50)

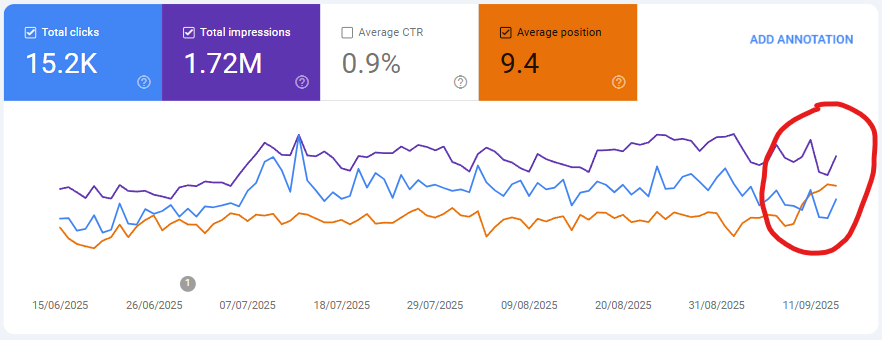

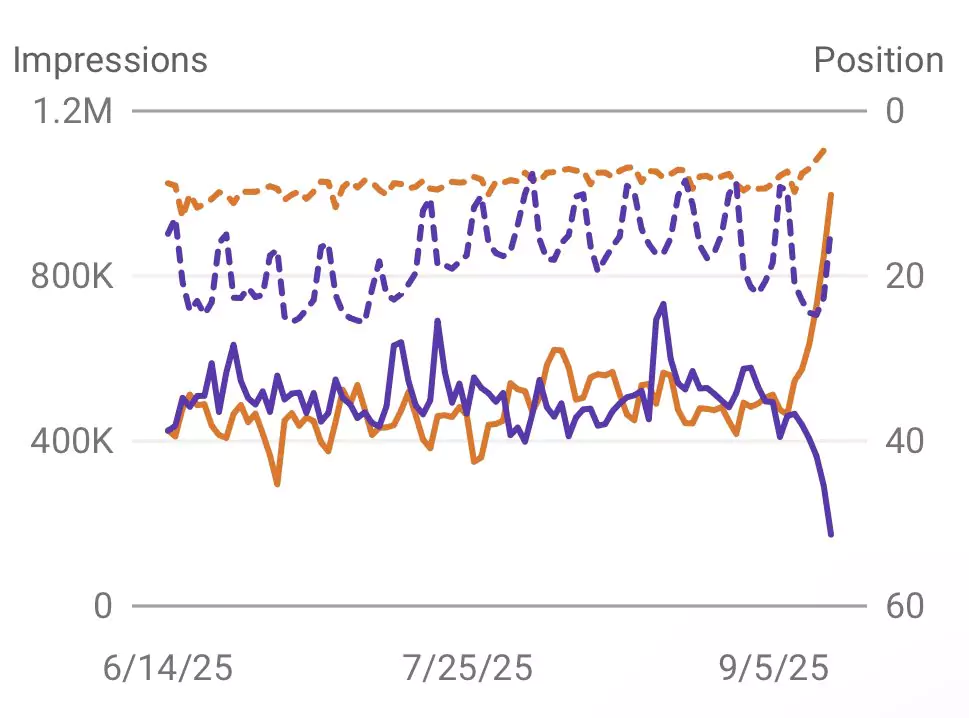

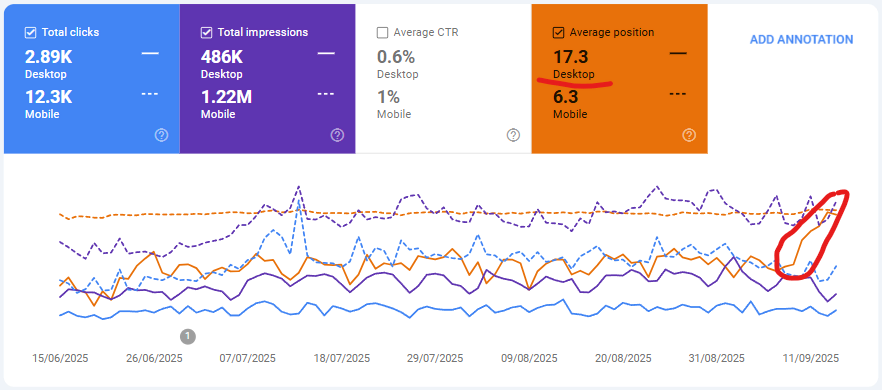

- Google Search Console: co ciekawe, problem dotknął również danych w GSC – przykład poniżej

Google Search Console też „oberwało”.

Na screenie widać wzrost średniej pozycji, bez zmiany liczby wyświetleń czy ruchu. Choć są zgłaszane przypadki, gdzie następuje drastyczny spadek wyświetleń.

A gdy porównamy desktop vs mobile – widać, że problem dotyka jedynie desktop (na mobile już od dawna nie ma opcji 100 wyników).

Przykład:

Przed zmianą miałeś średnią pozycję na poziomie 50, na którą składały się np pozycje 10 i 90 (duże przejaskrawienie, ale pokazuje, co się zmieniło), czyli prosty rachunek (10+90)/2=50. Obecnie Google przestał raportować pozycje powyżej 20, czyli mamy (10+20)/2=15. Twoja średnia pozycja wzrosła do 15 (sci!). Ale fraza nadal pojawia się w okolicach 90 pozycji, tylko Google widzi ją jako 20+. Niezły mindfuck 😉

Strategiczne motywacje Google

Budowanie „zamkniętego ogrodu”

Głównym celem jest utrudnienie masowego scrapingu danych – w dobie wyścigu AI dane z wyszukiwarki stanowią strategiczny zasób. Firmy rozwijające modele językowe wykorzystują je do trenowania systemów, stanowiąc bezpośrednie zagrożenie dla dominacji Google.

Ograniczając dostęp do wyników, Google wznosi wyższy mur wokół swojego „ogrodzonego ogrodu” danych, utrudniając konkurentom analizę unikalnych zasobów.

Monetyzacja i dominacja rynkowa

Decyzja ma solidne fundamenty ekonomiczne:

- Zwiększone przychody z reklam: Zmuszenie do przeglądania większej liczby stron naturalnie podnosi liczbę wyświetleń reklam

- Presja na branżę SEO: Podniesienie kosztów dla branży narzędzi SEO można traktować jako nałożenie „podatku”, osłabiającego finansowo firmy trzecie

Przyszłość napędzana AI

Zmiana harmonizuje z wizją wyszukiwania, gdzie tradycyjne listy linków zastępują odpowiedzi generowane przez AI (AI Overviews czy AI mode). W tym modelu przeglądanie 100 wyników staje się archaiczne – ograniczając tę opcję, Google przyzwyczaja użytkowników do nowego stylu interakcji.

Strategia milczenia

Najbardziej znaczące jest całkowite milczenie Google – brak jakiegokolwiek oficjalnego komunikatu. To świadoma demonstracja siły: działając po cichu, firma unika konfrontacji, stawiając branżę przed faktem dokonanym. To sygnał, że Google nie traktuje już społeczności SEO jako partnerów, lecz jako rynek, któremu można dyktować jednostronne warunki.

Nawigacja w nowej rzeczywistości

Wyzwania dla platform SEO

Platformy analityczne muszą radzić sobie z barierami technicznymi Google, takimi jak limity zapytań i CAPTCHA, wymagając inwestycji w kosztowną infrastrukturę obejmującą sieci proxy i systemy maskowania.

Oficjalne API Google, jak Search Console, oferują ograniczony dostęp do danych, nie zastępując bezpośredniego scrapingu, szczególnie w analizie konkurencji.

Niewidoczne konsekwencje: nauka i dziennikarstwo

Skutki wykraczają poza SEO – zmiana stanowi poważne utrudnienie dla badaczy akademickich i dziennikarzy śledczych, którzy wykorzystywali masową analizę wyników do badania trendów społecznych i dezinformacji. Wzrost kosztów dostępu może spowolnić postęp badań i podważyć ich replikowalność, wzmacniając kontrolę Google nad dyskursem o świecie cyfrowym.

Rekomendacje i wnioski

Dla agencji SEO i zespołów wewnętrznych

Konieczne działania obejmują:

- Dywersyfikację źródeł danych: Zmniejszenie zależności od jednego źródła poprzez integrację Google Search Console, Bing Webmaster Tools i własnych systemów analitycznych

- Fokus na metrykach biznesowych: Priorytetowanie analizy ruchu, konwersji i przychodów nad monitoringiem setek słów kluczowych

- Edukację klientów: Transparentną komunikację o nowych realiach i ograniczeniach raportowania

Dla dostawców narzędzi SEO

Branża stoi przed wyzwaniem transformacyjnym:

- Inwestycje w odporną technologię: Rozwój zaawansowanych, etycznych technologii scrapingu lub poszukiwanie alternatywnych źródeł danych

- Transparentność: Użytkownicy muszą znać metodologię zbierania danych i potencjalne ograniczenia

- Innowacje poza rankingami: Rozwijanie funkcji mniej zależnych od danych SERP – auditów technicznych, analiz treści, integracji z AI

Sumując

Usunięcie parametru &num=100 to więcej niż zmiana techniczna – to symboliczny krok w stronę absolutnej kontroli Google nad swoim ekosystemem. Przyspiesza transformację wyszukiwarki z otwartego narzędzia w zamkniętą platformę dostarczającą odpowiedzi.

Era swobodnej analizy danych wyszukiwarki dobiega końca, ustępując miejsca nowemu porządkowi, gdzie zasady gry dyktuje wyłącznie właściciel platformy. To nie koniec świata SEO, ale definitywny koniec świata, jaki znaliśmy.